谷歌 Gemini 技术报告 LaTeX 代码下载

备受关注的谷歌「原生多模态大模型」Gemini,其宣称超越 GPT-4 的强大性能,以及对于图像、视频等领域的理解能力让人们似乎看到了未来。这两天,谷歌 Gemini 技术报告完整版,终于出炉了。 60 多页技术报告,或许可以为我们的许多疑惑进行更加直观的解释。

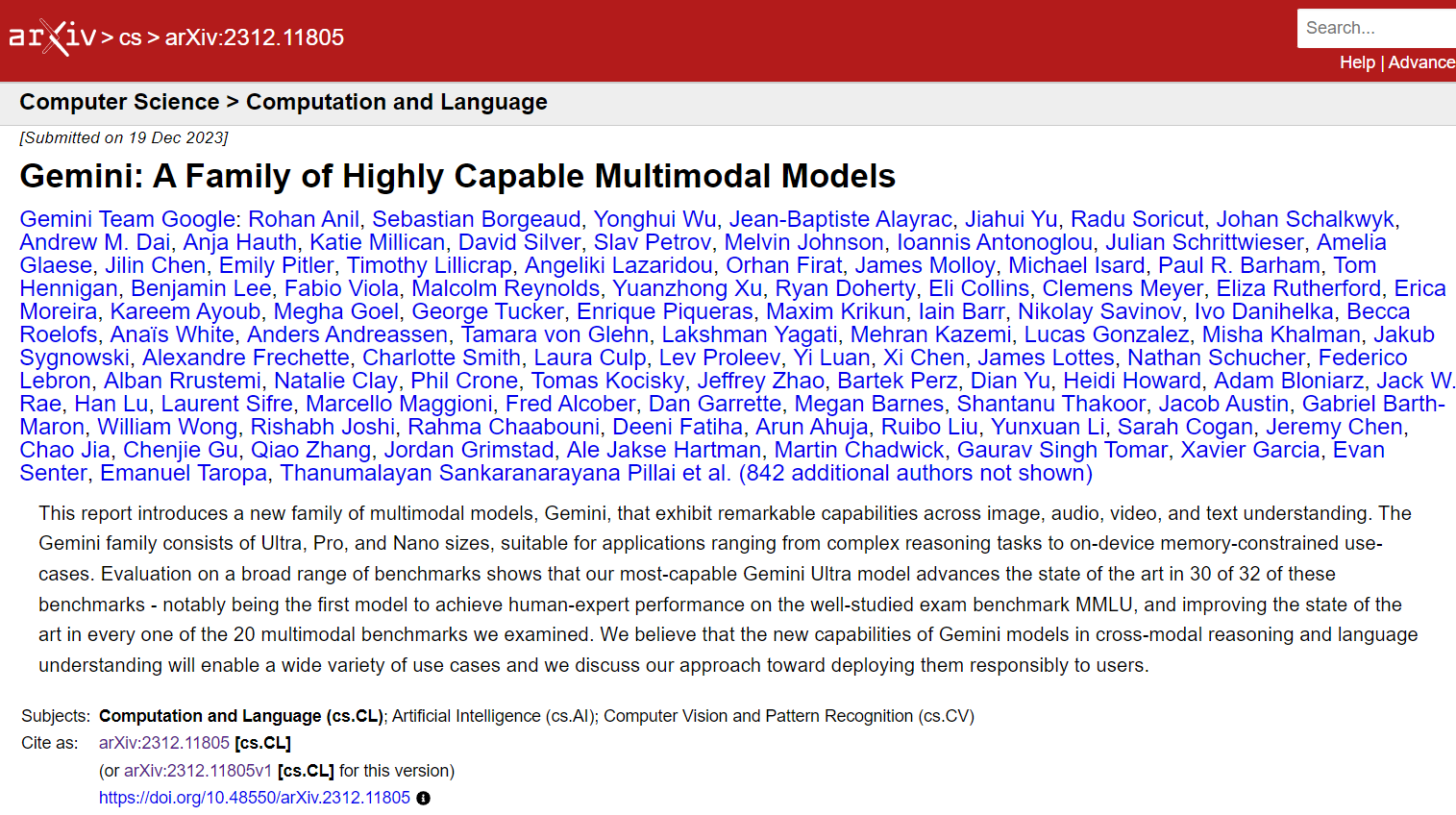

这篇技术报告《Gemini: A Family of Highly Capable Multimodal Models》作者包括 Jeff Dean、Oriol Vinyals、Koray Kavukcuoglu、Demis Hassabis 等一众谷歌研究大佬,另外还有谢尔盖・布林这样的公司联合创始人。

论文链接:https://arxiv.org/abs/2312.11805

另外,该文章的作者数量也夺人眼球 ——941 个人,真正是超越历史记录了。从文章第 35 页起,谷歌开始罗列所有「贡献者」,从 Team Leader 到主要贡献者,再到贡献者分门别类写到了第 45 页, 论文作者比解释技术写的还长,这怕不是在水字数?

论文概要

这篇论文介绍了一种名为 Gemini 的新型多模态模型家族,该家族在图像、音频、视频和文本理解方面表现出卓越的能力。Gemini 家族包括 Ultra、Pro 和 Nano 三种尺寸,适用于从复杂推理任务到设备内存受限用例的应用程序。在广泛的一组基准测试中,我们最强大的 Gemini Ultra 模型在 32 个基准测试中的 30 个上推进了最先进水平——值得注意的是,首次在广受研究的考试基准 MMLU 上实现了人类专家性能,并在我们检查的 20 个多模态基准测试中改善了最先进水平。我们认为,Gemini 模型在跨模态推理和语言理解方面的新能力将使各种用例成为可能,我们讨论了将它们负责任地部署到用户的方法。--by chatglm

不少网站都对论文进行了详细解读,大家可以自行搜索查找。这里就不再赘述了。

LaTeX 源代码获取

我们分享的重点还是其报告的 LaTeX 排版源代码,这个技术报告,Google 自己定义了一个模版上传的,源代码还有些错误,我下载到本地进行了部分修正,主要是参考文献太多问题,整体保证可以编译通过。

获取方式,可以关注我们公众号,回复:Google 获取源代码+PDF 下载链接吧。

公众号在下面: